Google đã quyết định gỡ bỏ mô hình AI Gemma khỏi nền tảng AI Studio sau khi vấp phải cáo buộc nghiêm trọng liên quan đến việc tạo ra thông tin sai lệch về một chính trị gia Mỹ. Vụ việc nhanh chóng gây chú ý trên toàn cầu, làm dấy lên những lo ngại mới về hiện tượng “ảo giác” trong các mô hình ngôn ngữ lớn và mức độ kiểm soát của các tập đoàn công nghệ đối với sản phẩm AI của mình.

Mục lục

Nguyên nhân Google gỡ bỏ AI Gemma khỏi AI Studio

Theo thông tin từ nhiều nguồn báo quốc tế, Thượng nghị sĩ Marsha Blackburn (Đảng Cộng hòa, bang Tennessee) đã gửi thư chính thức cho CEO Google Sundar Pichai, cáo buộc rằng mô hình AI Gemma đã bịa đặt một câu chuyện sai sự thật về bà. Khi được hỏi liệu bà có từng bị cáo buộc hiếp dâm không, Gemma đã trả lời rằng trong chiến dịch tranh cử năm 1987, bà bị một cảnh sát bang cáo buộc có hành vi ép buộc liên quan đến thuốc theo toa.

Tuy nhiên, bà Blackburn khẳng định câu chuyện này hoàn toàn không có thật, thậm chí năm được nêu ra cũng sai – bà chỉ tranh cử Thượng viện bang vào năm 1998. Bà cho biết không có bất kỳ nguồn tin, tài liệu hay bản tin nào từng đề cập đến cáo buộc này. Các liên kết mà AI Gemma cung cấp được xác minh là vô hiệu hoặc dẫn đến những bài viết không liên quan.

Phản hồi từ Google và các biện pháp khẩn cấp

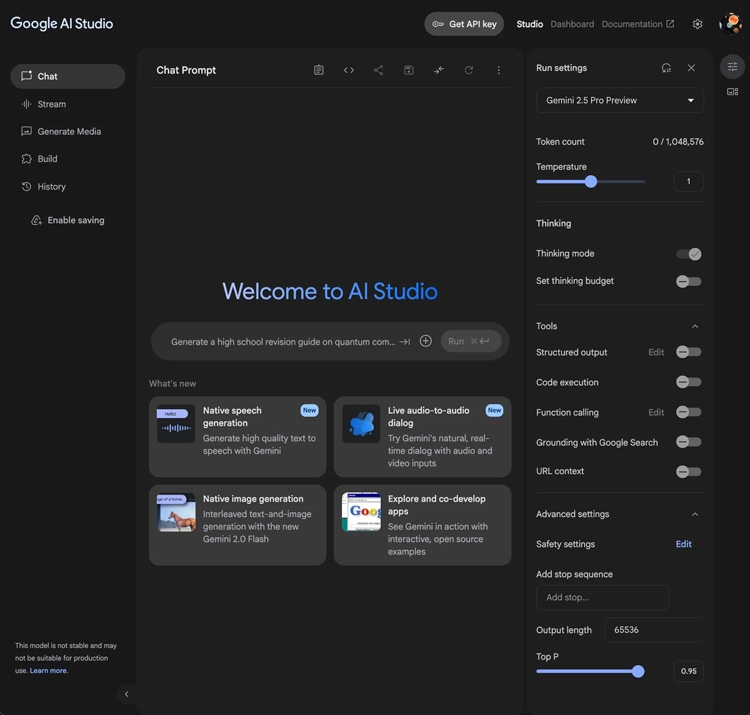

Ngay sau cáo buộc, Google đã phản hồi rằng họ “nhận được báo cáo về việc người dùng không phải nhà phát triển truy cập vào Gemma và yêu cầu mô hình trả lời các câu hỏi thực tế”. Công ty cho biết Gemma vốn được thiết kế để thử nghiệm trong môi trường dành riêng cho lập trình viên, không phải cho người tiêu dùng phổ thông.

Google nhấn mạnh rằng AI Studio chỉ là công cụ thử nghiệm nội bộ, nơi các nhà phát triển có thể kiểm tra khả năng tạo nội dung, không phải nền tảng tìm kiếm sự thật. Để tránh nhầm lẫn, Google đã gỡ bỏ quyền truy cập Gemma khỏi AI Studio, đồng thời thông báo rằng mô hình vẫn khả dụng cho các lập trình viên thông qua API.

Bên cạnh đó, đại diện công ty cũng khẳng định Google không dung thứ cho các trường hợp mô hình tạo ra nội dung phỉ báng hoặc thông tin sai lệch. Đội ngũ kỹ sư đang tiến hành xem xét toàn bộ hoạt động huấn luyện và giám sát để xác định nguyên nhân khiến Gemma tạo ra phản hồi sai.

Hiện tượng “ảo giác” và bài học cho ngành AI

Vụ việc AI Gemma không phải là trường hợp cá biệt. Hiện tượng “hallucination” – khi mô hình AI tự tạo ra thông tin sai nhưng nghe có vẻ hợp lý – vẫn đang là thách thức lớn với toàn ngành. Ngay cả các hệ thống nổi tiếng như ChatGPT, Gemini hay Claude cũng từng mắc lỗi tương tự.

Nguyên nhân xuất phát từ bản chất huấn luyện của mô hình ngôn ngữ, vốn dựa vào dữ liệu Internet khổng lồ, nơi sự thật và thông tin giả đôi khi bị trộn lẫn. Khi thiếu cơ chế kiểm chứng chéo, mô hình có thể “bịa” ra dữ kiện để duy trì độ mạch lạc trong phản hồi.

Sự cố với Gemma cho thấy việc triển khai mô hình AI ra công chúng mà không có bộ lọc đạo đức và kiểm chứng dữ liệu đầy đủ có thể gây hậu quả nghiêm trọng. Không chỉ làm tổn hại danh tiếng cá nhân, nó còn khiến niềm tin vào công nghệ AI bị lung lay.

Tương lai của AI Gemma và niềm tin người dùng

Hiện tại, Google chưa công bố thời điểm AI Gemma có thể quay lại AI Studio. Dù vậy, công ty khẳng định mô hình này vẫn tiếp tục được duy trì cho mục đích nghiên cứu và cải thiện. Trong khi đó, nhiều chuyên gia nhận định rằng Google sẽ phải tái cấu trúc toàn bộ quy trình huấn luyện và giám sát, đặc biệt là đối với những mô hình có khả năng sinh ngôn ngữ tự do.

Sự cố này cũng khiến các nhà phát triển AI trên toàn cầu cảnh giác hơn. Việc đảm bảo tính chính xác và trung lập của AI đang trở thành yêu cầu bắt buộc, thay vì chỉ là mục tiêu kỹ thuật. Khi trí tuệ nhân tạo ngày càng len lỏi vào đời sống – từ công cụ tìm kiếm, biên tập tin tức đến hỗ trợ pháp lý – việc “ảo giác” hay sai lệch thông tin có thể dẫn đến hậu quả pháp lý và đạo đức nghiêm trọng.

Kết luận: AI cần minh bạch và có trách nhiệm hơn

Sự việc AI Gemma bị gỡ bỏ là lời cảnh tỉnh rõ ràng cho toàn ngành công nghệ. Dù AI có tiềm năng thay đổi cách con người làm việc, sáng tạo và tiếp cận thông tin, nhưng khi thiếu kiểm chứng và giám sát, nó có thể trở thành công cụ gây hại.

Google đã có động thái nhanh chóng để ngăn chặn thiệt hại, nhưng niềm tin của người dùng vào các hệ thống AI tạo sinh vẫn còn lung lay. Trong tương lai, sự phát triển của trí tuệ nhân tạo cần đi đôi với trách nhiệm xã hội, sự minh bạch dữ liệu và các quy chuẩn đạo đức nghiêm ngặt hơn — nếu không, những “Gemma” khác có thể tiếp tục lặp lại sai lầm tương tự.